Если вы хотите запустить Large Language Models или LLMs на своем компьютере, один из самых простых способов сделать это — через Ollama. Ollama — это мощная платформа с открытым исходным кодом, которая предлагает настраиваемый и легкодоступный опыт ИИ. Она позволяет легко загружать, устанавливать и взаимодействовать с различными LLMs, без необходимости полагаться на облачные платформы или требовать каких-либо технических знаний.

В дополнение к вышеперечисленным преимуществам, Ollama довольно легковесна и регулярно обновляется, что делает ее вполне подходящей для создания и управления LLM на локальных машинах. Таким образом, вам не нужны никакие внешние серверы или сложные конфигурации. Ollama также поддерживает несколько операционных систем, включая Windows, Linux и macOS, а также различные среды Docker.

Загрузка и установка Ollama

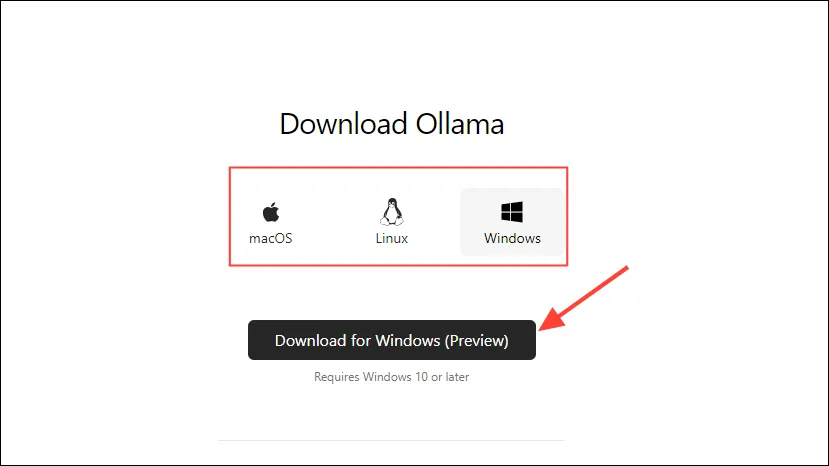

- Сначала посетите страницу загрузки Ollama и выберите свою ОС, прежде чем нажать кнопку «Загрузить».

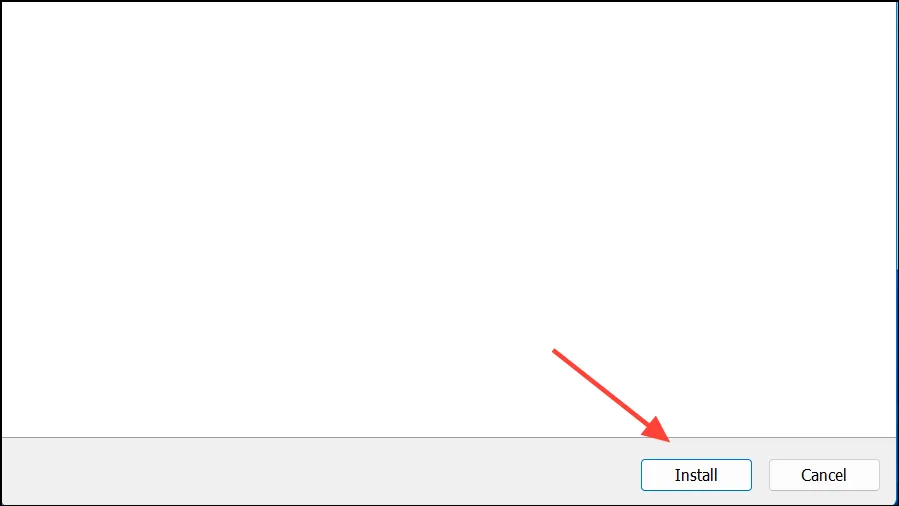

- После завершения загрузки откройте ее и установите на свой компьютер. Установщик автоматически закроется после завершения установки.

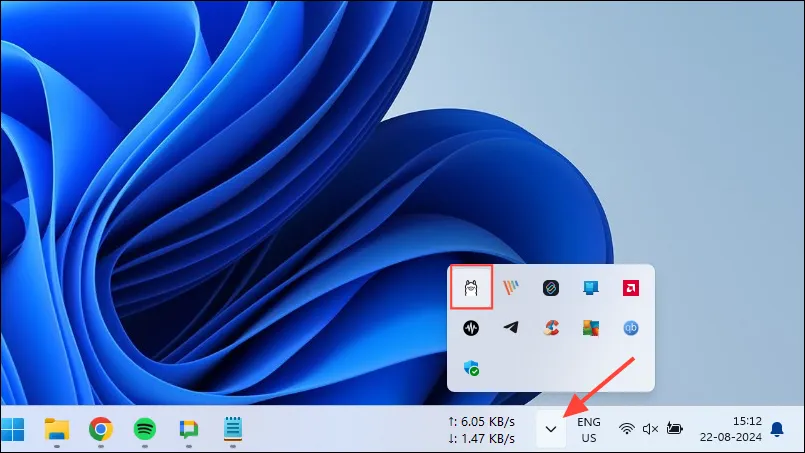

- В Windows вы можете проверить, запущен ли Ollama, нажав на кнопку переполнения панели задач, чтобы просмотреть скрытые значки.

Настройка и использование Ollama

После установки Ollama на ваш компьютер, первое, что вам следует сделать, это изменить место хранения данных. По умолчанию местом хранения является , C:\Users\%username%\.ollama\modelsно поскольку модели ИИ могут быть довольно большими, ваш диск C может быстро заполниться. Чтобы сделать это,

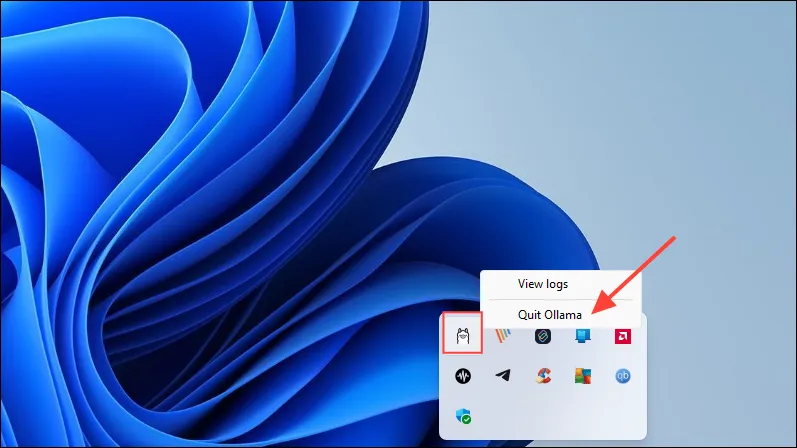

- Сначала щелкните значок Ollama на панели задач и нажмите «Выйти из Ollama».

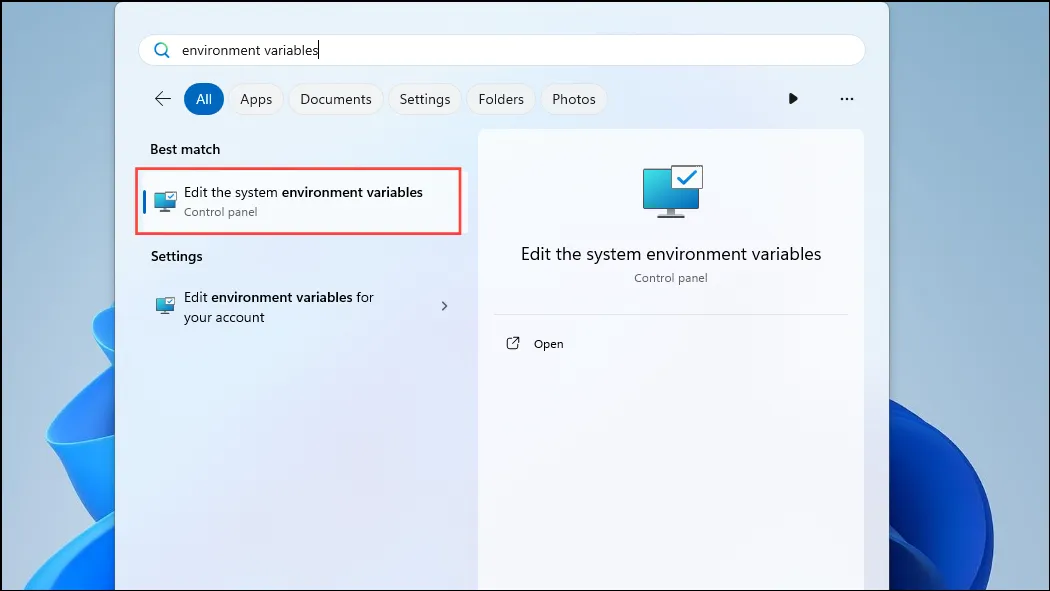

- После выхода из Ollama откройте меню «Пуск», введите

environment variablesи нажмите «Изменить переменные среды системы».

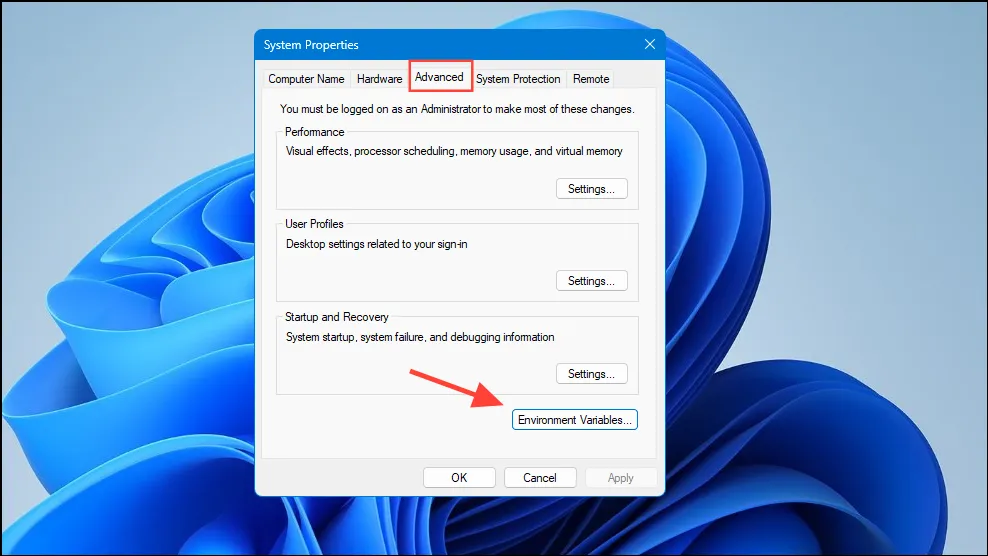

- Когда откроется диалоговое окно «Системные переменные», нажмите кнопку «Переменные среды» на вкладке «Дополнительно».

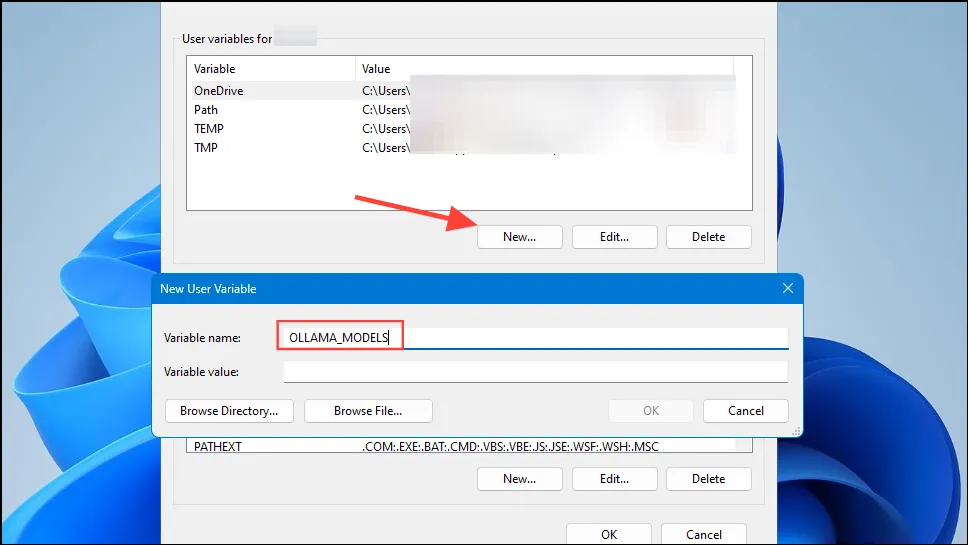

- Нажмите кнопку «Новый» для своей учетной записи пользователя и создайте переменную, указав ее

OLLAMA_MODELSимя в поле «Имя переменной».

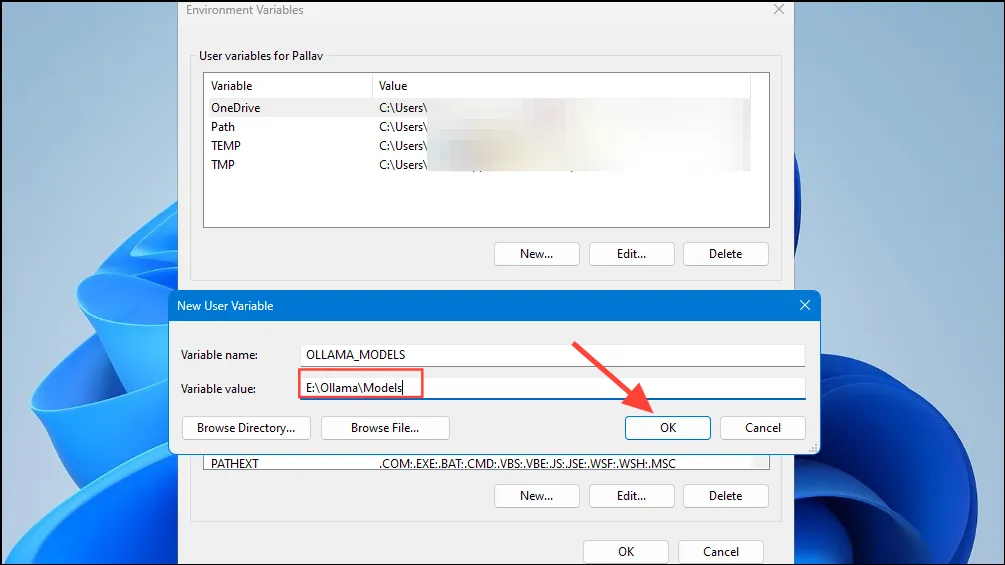

- Затем введите местоположение каталога, в котором вы хотите, чтобы Ollama хранила свои модели, в поле «Значение переменной». Затем нажмите кнопку «ОК» перед запуском Ollama из меню «Пуск».

- Теперь вы готовы начать использовать Ollama, и вы можете сделать это с помощью Llama 3 8B от Meta, последней модели ИИ с открытым исходным кодом от компании. Чтобы запустить модель, запустите командную строку, Powershell или окно Windows Terminal из меню «Пуск».

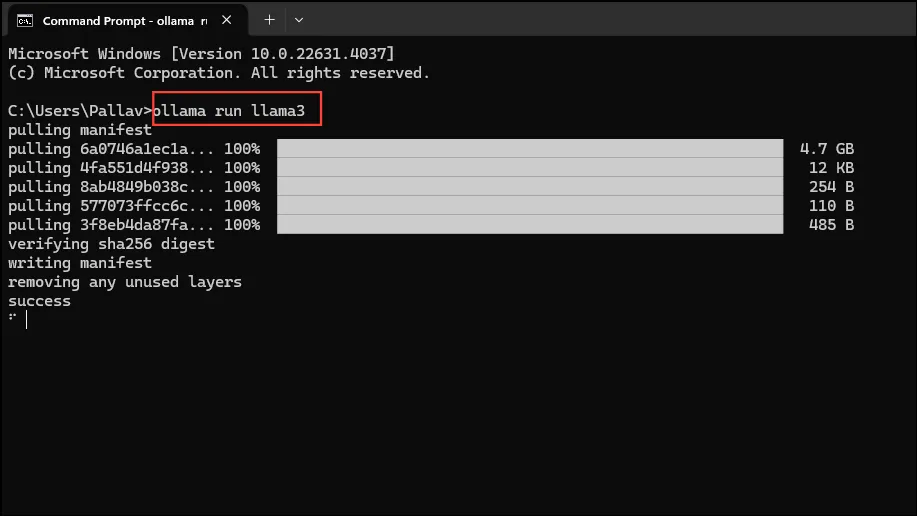

- После того, как откроется окно командной строки, введите

ollama run llama3и нажмите Enter. Модель весит около 5 ГБ, поэтому ее загрузка займет некоторое время.

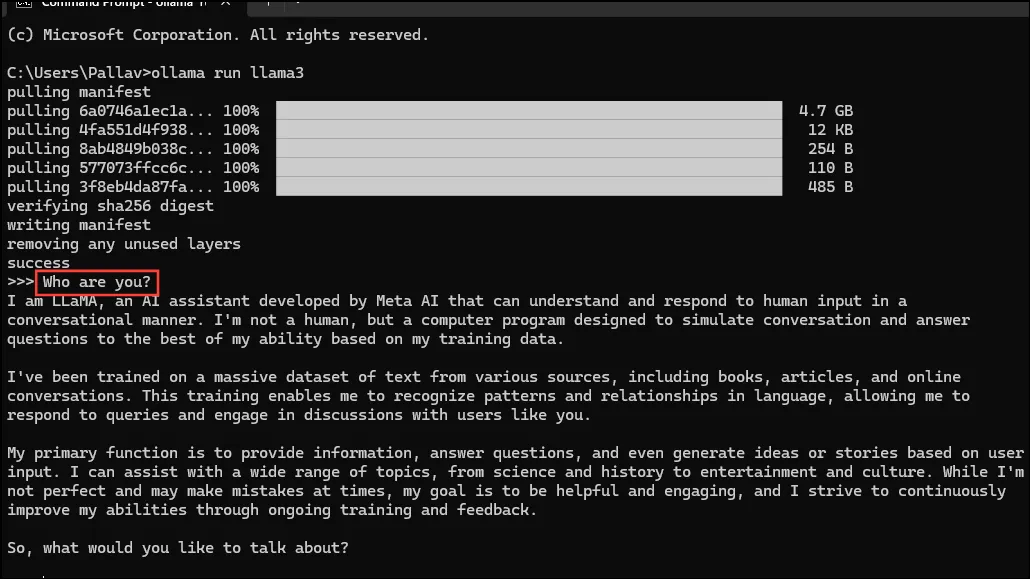

- После завершения загрузки вы можете начать использовать Llama 3 8B и общаться с ней напрямую в окне командной строки. Например, вы можете спросить модель

Who are you?и нажать Enter, чтобы получить ответ.

- Теперь вы можете продолжить разговор и задать вопросы моделям ИИ на разные темы. Просто помните, что Llama 3 может ошибаться и галлюцинировать, поэтому будьте осторожны при его использовании.

- Вы также можете попробовать другие модели, посетив страницу библиотеки моделей Ollama. Кроме того, есть различные команды, которые вы можете запустить, чтобы попробовать различные функции, которые предлагает Ollama.

- Во время работы модели вы также можете выполнять различные операции, такие как настройка переменных сеанса, отображение информации о модели, сохранение сеанса и многое другое.

- Ollama также позволяет использовать мультимодальные модели ИИ для распознавания изображений. Например, модель LLava может распознавать изображения, сгенерированные DALLE-3. Она может подробно описывать изображения.

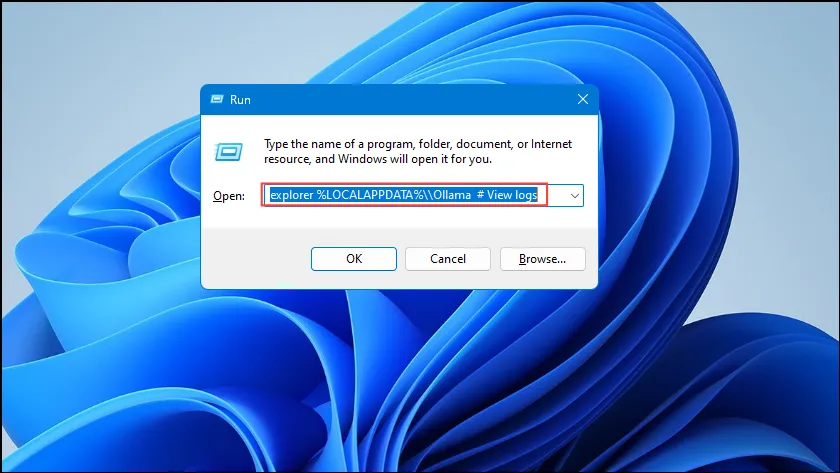

- Если вы сталкиваетесь с ошибками при запуске Ollama, вы можете проверить журналы, чтобы узнать, в чем проблема. Используйте сочетание клавиш

Win + R, чтобы открыть диалоговое окно «Выполнить», а затем введитеexplorer %LOCALAPPDATA%\\Ollama # View logsв него текст, прежде чем нажать Enter.

- Вы также можете использовать другие команды, такие как

explorer %LOCALAPPDATA%\\Programs\\Ollamaи ,explorer %HOMEPATH%\\.ollamaчтобы проверить место хранения двоичных файлов, модели и конфигурации.

Что нужно знать

- Ollama автоматически определяет ваш GPU для запуска моделей ИИ, но на машинах с несколькими GPU он может выбрать неправильный. Чтобы избежать этого, откройте Панель управления Nvidia и установите для параметра Display значение «Nvidia GPU Only».

- Режим отображения может быть доступен не на каждом компьютере, а также отсутствовать при подключении компьютера к внешним дисплеям.

- В Windows вы можете проверить, использует ли Ollama правильный графический процессор, с помощью диспетчера задач, который покажет использование графического процессора и сообщит, какой из них используется.

- Хотя установка Ollama на macOS и Linux немного отличается от Windows, процесс запуска LLM через нее довольно схож.

Добавить комментарий